أعلنت شركة علي بابا للتو رسميًا عن أحدث نموذج استدلالي لها، ويبدو أن شركتي DeepSeek وOpenAI لديهما بعض الأسباب للقلق - إذا كانت كل "الضجة" التي أثيرت حول علي بابا صحيحة. هذا النموذج مفتوح المصدر، لذا يمكن لأي شخص الوصول إليه وتجربته مجانًا.

يعتمد نموذج الذكاء الاصطناعي الجديد من علي بابا، والذي أطلق عليه اسم QwQ-32b (Quan-with-Questions)، على معلمات أقل بكثير من جميع نماذج اللغة الرئيسية اليوم تقريبًا، مما يعني أنه يتطلب موارد أقل. تزعم شركة علي بابا أن أداء QwQ-32b هو نفس مستوى DeepSeek أو o1-mini من OpenAI.

أحدث نموذج اللغة الكبير DeepSeek-R1 (LLM) ضجة كبيرة عندما تم إطلاقه في أوائل فبراير، حيث تحدى المعيار الذهبي الذي وضعه ChatGPT، ولكن بتكلفة تشغيل أقل بكثير. ويبدو أن شركة علي بابا تريد دفع هذا الحد إلى أبعد من ذلك من خلال QwQ-32b.

من الناحية الفنية، يتطلب DeepSeek-R1 671 مليار معلمة للتشغيل، مع تمكين 37 مليار معلمة. في غضون ذلك، يحتاج QwQ-32b من شركة علي بابا إلى 32 مليار معلمة فقط. قد تبدو هذه الأرقام مجردة بالنسبة للعديد من الأشخاص، ولكنها تحدث فرقًا كبيرًا في قوة الحوسبة: فبينما يتطلب DeepSeek-R1 1600 جيجابايت من ذاكرة VRAM للعمل، يحتاج QwQ-32b فقط إلى 24 جيجابايت من ذاكرة VRAM. في معظم الحالات، سيتطلب هذا بطاقة رسوميات مثل Nvidia H100 أو ما يع��دلها، ولكن حتى بطاقة RTX 4090 الصديقة للاعبين تحتوي على 24 جيجابايت من ذاكرة VRAM. يرفع أحدث إصدار من RTX 5090 هذا الرقم إلى 32 جيجابايت.

ويقال أيضًا أنه حتى مع 32 مليار معلمة فقط، فإن QwQ-32B لا يزال يعطي أداءً مساويًا أو متفوقًا على R1 في مجالات مثل الرياضيات والبرمجة وحل المشكلات العامة. وقالت شركة علي بابا أيضًا إن QwQ-32B يتفوق على o1-mini من OpenAI، والذي تم بناؤه بـ 100 مليار معلمة. يتوفر QwQ-32B على Hugging Face، وهو أكبر مجتمع نماذج الذكاء الاصطناعي مفتوح المصدر في العالم.

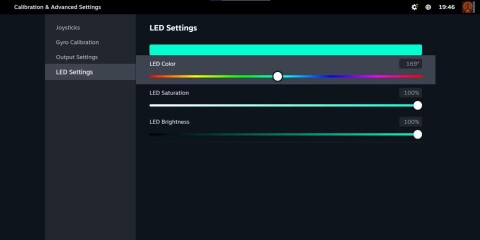

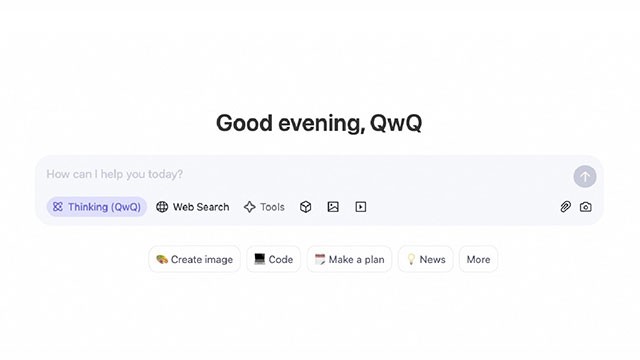

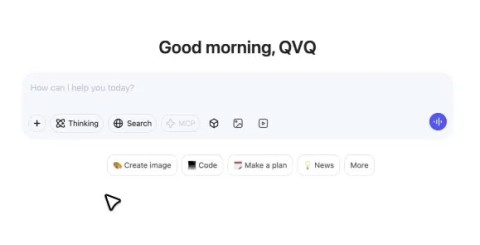

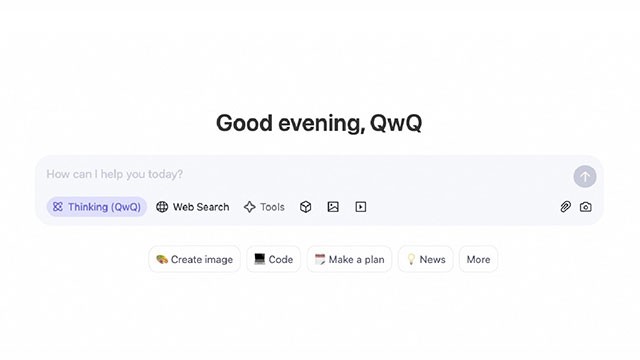

يتوفر نظام QwQ-32b من شركة Alibaba بموجب ترخيص Apache 2.0، مما يعني أن الشركات والباحثين يمكنهم استخدامه بحرية. والأهم من ذلك، يمكننا تجربته من خلال تطبيق Qwen Chat التابع لشركة Alibaba. مثل DeepSeek، فإن QwQ-32b لديه بعض القيود فيما يتعلق بحدود الموضوع. على سبيل المثال، عند سؤال أحد الأشخاص عن قضايا سياسية، سيعطي Qwen Chat رسالة مفادها أن هذا موضوع غير مناسب. ولكن هناك أيضًا بعض المزايا التي تظهر فورًا.

يبدو أن QwQ-32b يعطي إجابات مفصلة للغاية حتى للأسئلة السريعة والبسيطة. قد يكون هذا جيدًا، ولكن بطريقة ما، فهو مزعج للغاية لأنه يوفر الكثير من المعلومات غير الضرورية التي لم تطلبها. الميزة الإيجابية الوحيدة هي أن QwQ-32b يمكنه عرض عملية التفكير بأكملها، على غرار ميزة التفكير العميق في ChatGPT — ولكن بعمق أقل.

يبقى أن نرى ما إذا كانت ادعاءات علي بابا ستتحقق، ولكن يبدو أن ChatGPT و DeepSeek لديهما الآن منافس جديد جدير بالاهتمام.